Die Null hat einen schlechten Ruf: Ein Versager ist eine Null; ein Unternehmen, das eine schwarze Null schreibt, dümpelt vor sich hin. Dabei ist die Null für unser Zahlensystem entscheidend; sie zu entwickeln, dauerte Jahrtausende.

Am Anfang war das Zählen. Im Kalbsledergürtel, den er stets bei sich trug, zählte Ötzi vier Werkzeuge: Einen Klingenkratzer, einen Bohrer, eine Feuersteinklinge und eine Ahle. Doch das Zählen hatte Grenzen: Die Blätter an den Bäumen, die Steine im Fluss, die Sterne am Himmel – sie blieben, ihrer Unendlichkeit wegen, unzählbar. Mit dem Bezeichnen grosser Mengen taten sich die Menschen lange Zeit schwer. Im römischen Zahlensystem, in Europa bis ins 16. Jahrhundert in Gebrauch, benötigten alle Zehnerpotenzen und alle dazwischen liegenden Fünferwerte einen eigenen Buchstaben – «X» hiess 10, «L» 50, «C» 100, «D» 500. Während die Zahl 1000 mit der Schreibung «M» noch ausgesprochen handlich war, schrieb sich die Zahl 1 234 567 in römischen Ziffern MCCXXXIV•MDLXVII – oder auch nicht: Für grosse Werte existierten im römischen Reich gleich mehrere konkurrierende Schreibweisen. Schriftliche Rechenoperationen, wie wir sie in der Schule gelernt haben und die das Addieren und Subtrahieren, Multiplizieren und Dividieren erleichtern, gab es nicht.

Dazu kam, dass die Römer und ihre zählenden Nachfahren keinen Begriff für das Nichts hatten. Eine Null kam im römischen Zahlensystem nicht vor. Zahlen dienten dazu, das Ergebnis des Zählens konkreter Güter festzuhalten, und «0» oder «-7» wären unsinnige Antworten auf die Frage gewesen, wie viele Ochsen ein Bauer zum Pflügen braucht. In Europa sollte es bis ins 16. Jahrhundert dauern, bis der deutsche Rechenmeister Adam Ries die wahre Bedeutung der Null erkannte: Sie ermöglichte eine einfache tabellarische Addition und Subtraktion, und dank ihr liessen sich unendlich grosse Zahlen mit einer endlichen Anzahl Ziffern ausdrücken.

Der Ursprung der Null liegt im Stellenwert- oder Positionssystem der alten Babylonier. Schrifttafeln aus der Zeit um 1700 v. Chr. enthalten Zahlen in Keilschrift, die auf dem Sexagesimalsystem beruhen (also auf der Basis 60 statt unserer heutigen 10) und die aus Zeichen bestehen, deren Position ihren Wert angibt. Doch auch die Babylonier kannten noch keine Null: 216 konnte ebenso gut 2016 oder 2106 bedeuten – der genaue Wert erschloss sich nur durch den Kontext. Erst um 400 v. Chr. begannen babylonische Schreiber, an die Stelle unserer heutigen Null zwei kleine Keile zu setzen, so dass sich 216 von 2‘‘16 unterschied. Indes: Mit unserer Null hatten die beiden Keile immer noch wenig zu tun: Nirgendwo nämlich tauchen sie am Ende einer Zahl auf – ob 216 oder 2160, ergab sich nach wie vor nur aus dem Zusammenhang. (Kontextabhängige Werte kennen wir im übrigen auch heute noch: «Two forty» auf die Frage nach dem Preis einer Londoner Busfahrkarte bedeutet zwei Pfund 40 Pence; geht es dagegen um ein Flugticket nach Paris, heisst «two forty» 240 Pfund.)

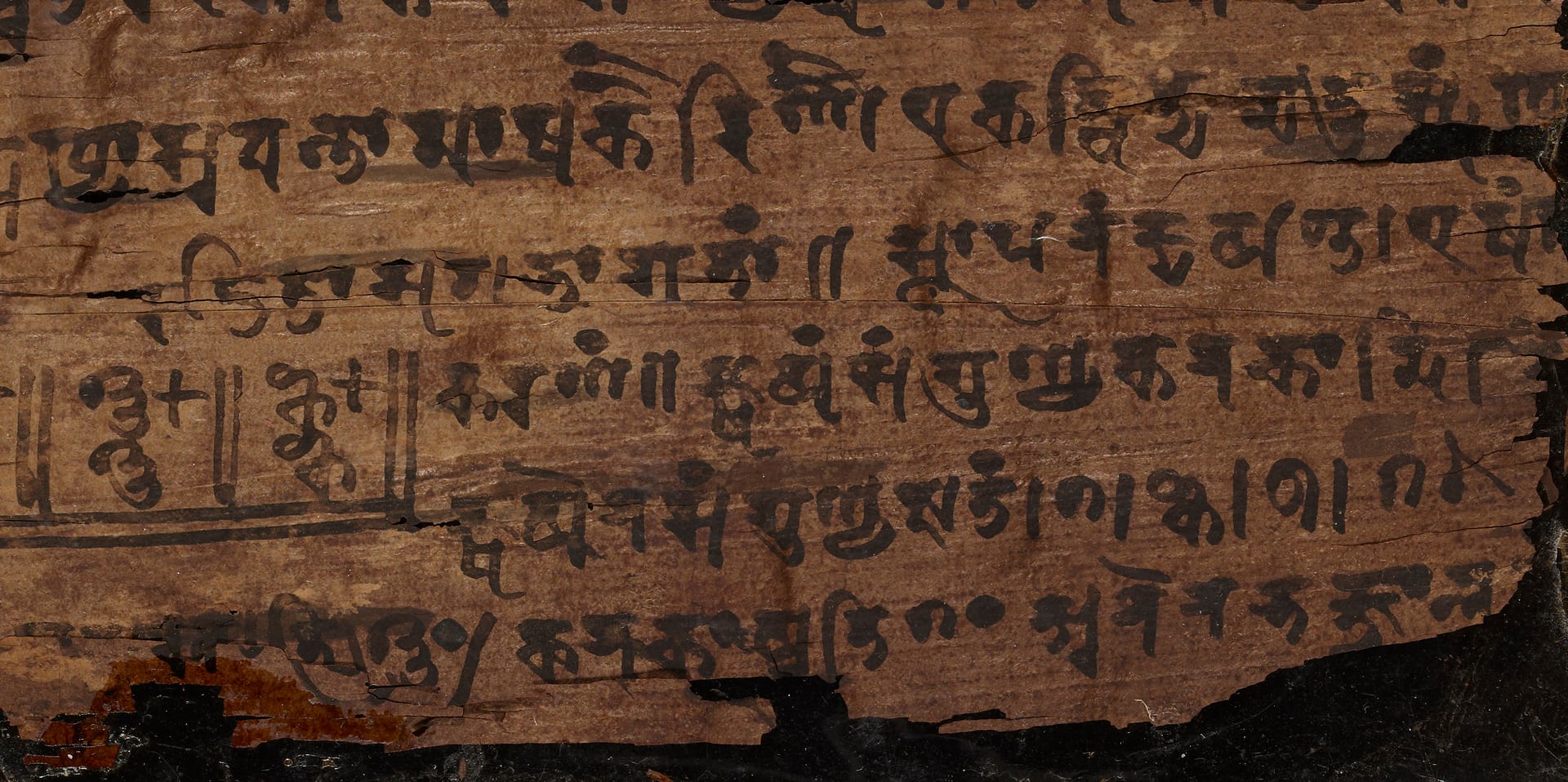

Das moderne Konzept der Null hat seinen Ursprung da, wo auch unsere Ziffern herkommen: in Indien. Forscher der Universität Oxford haben in einem 1800 Jahre alten, aus dem heute in Pakistan liegenden Dorf Bakhshali stammenden Manuskript die moderne Proto-Null entdeckt – in der Form eines schlichten Punkts. Aus diesem Punkt sollte sich über viele Jahrhunderte hinweg unsere bauchige Null entwickeln – und mit ihr ein abstraktes, vom einfachen Zählen losgelöstes arithmetisches System, das auch negative Werte zulässt. Selbst wenn sie, für sich allein, einen Nicht-Wert bedeutet, verdient die Null gehörigen Respekt – als eine der herausragendsten Leistungen der Wissenschaft.